10. Juni 2024, 22:47 Uhr | Lesezeit: 6 Minuten

Auf der WWDC 2024 hat Apple sein eigenes KI-System vorgestellt. Damit kommt eine Flut von neuen Funktionen für iPhone, iPad und Mac. TECHBOOK erklärt die Einzelheiten.

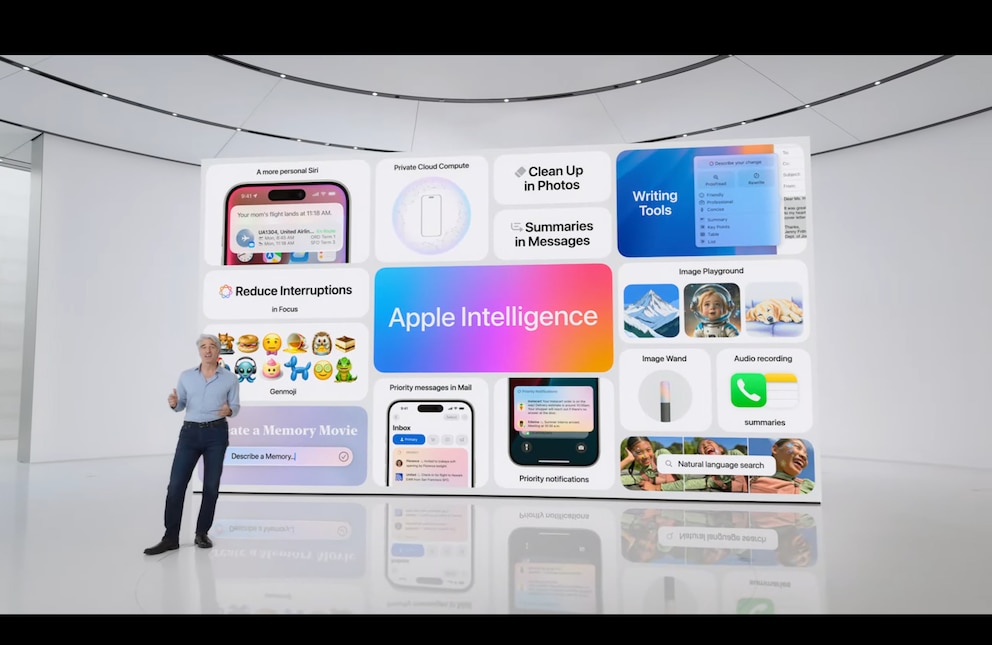

Künstliche Intelligenz hat die gesamte zweite Hälfte der Keynote zur WWDC 2024 eingenommen. Wie erwartet hat das Ganze jedoch einen eigenen Apple-Twist. Denn das System heißt „Apple Intelligence“ und hat somit die gleiche Abkürzung, „AI“, wie Artificial Intelligence (dt. Künstliche Intelligenz). Das Unternehmen nennt es „KI für den Rest von uns“ und hebt damit hervor, dass sein neues System für die Bedürfnisse der Nutzer entwickelt wurde. Neben iPhones sollen auch iPads und Macs Apple Intelligence bekommen.

Übersicht

Generative KI in iOS, iPadOS und macOS

Apple hat auf der WWDC 2024 KI-generierte Emojis – oder „Genmojis“ – vorgestellt. Damit können Nutzer für jede Situation spontan passende Emoji-Reaktionen erstellen, zusätzlich zu der bereits bestehenden Auswahl. Die Genmojis erscheinen direkt in der Tastatur auf dem iPhone. Nutzer müssen lediglich eine Beschreibung wählen und das System erstellt automatisch das passende Bild, das sich dann als Reaktion auf eine Nachricht, als Nachricht selbst oder als Sticker in iMessage verschicken lässt.

Apple Intelligence ist in der Lage, Sprachnotizen zu transkribieren, und Fotos mit KI nachzubearbeiten. Auch bei der Suche in Safari und über Spotlight soll Künstliche Intelligenz unterstützen. AI gibt Vorschläge für Antworten in E-Mails und Text-Nachrichten – ähnlich wie Google es bereits mit Gemini macht. Nutzer können dabei aus verschiedenen Entwürfen wählen und den Ton des Texts wählen – beispielsweise „freundlich“, „professionell“ oder „auf den Punkt“. Sogar kleine Gedichte sind im Repertoire der KI. Darüber hinaus kann Apple Intelligence Texte korrigieren und Verbesserungen vorschlagen. Auch die Zusammenfassung von wichtigen Punkten aus eigenen Texten als Stichpunkte ist möglich.

Image Playground

Apple gibt Nutzern eine Menge Spielraum beim Erstellen von Bildern. In unterstützten Apps (iMessage, Pages, Freeform) können sie aus drei Stilen auswählen: Animation, Illustration oder Skizze. Durch das Hinzufügen von Details lassen sich die Bilder auf die eigenen Vorstellungen anpassen. Das Feature erstellt Vorschauen, die komplett auf dem Gerät selbst berechnet werden – ohne Cloud-Zugriff.

Bildbearbeitung

Aus Google Photos hingegen hat Apple die Magic-Eraser-Funktion übernommen, die das Entfernen von Personen und Objekten aus einem Foto erlaubt. Die Fotos-App in iOS hat jedoch kein Pendant zum Magic Editor erhalten, mit dem sich Bilder im Nachhinein weitreichend manipulieren lassen – etwa durch Verschiebung, Vergrößerung oder Verkleinerung ganzer Ausschnitte.

Smart Reply

Smart Reply macht Antworten auf Nachrichten noch schneller, indem Nutzer gar keinen Text mehr eingeben müssen. AI erkennt automatisch, wenn etwa eine E-Mail eine Einladung enthält und eine Antwort erfordert. Nutzer können dann einfach anklicken, wer kommt und die Antwort wird automatisch verfasst.

Zusammenfassungen

Die Apple-KI kann Zusammenfassungen von verpassten Benachrichtigungen, Websites, Artikeln und anderen Text-Formen erstellen. Im E-Mail-Postfach können Nutzer auswählen, dass statt der ersten paar Zeilen eine kurze Zusammenfassung des Inhalts erscheint. Alle verpassten E-Mail lassen sich mit einem Tastendruck auf die wichtigsten Punkte reduzieren. Wichtige E-Mails – etwa mit einem Boarding-Pass und Einladungen – erscheinen automatisch ganz oben im Postfach.

Für den Sperrbildschirm gibt es eine neue Alternative zum Nicht-Stören-Modus, die Unterbrechungen reduzieren soll. Sie zeigt nur die Benachrichtigungen, die auch tatsächlich wichtig sind – zum Beispiel, wenn das Kind aus der Kita abgeholt werden muss.

Lesen Sie weiter: Alle Neuerungen in iOS 18

Siri wird endlich schlauer

Ein offensichtlicher Anknüpfungspunkt für generative KI ist Apples Sprachassistent Siri. Seit der Einführung im Jahr 2011 ist der einst bahnbrechende Assistent ins Hintertreffen geraten. Um wieder mit Google Assistant und Amazon Alexa – die ihre eigenen Probleme haben – mithalten zu können, war ein Neustart erforderlich.

Diesen liefert Apple Intelligence. Siri bekommt einen komplett neuen Look auf dem iPhone. Nicht nur ändert sich das Icon – auch die Integration in iOS wirkt nun deutlich tiefer. Beim Aktivieren des Sprachassistenten leuchtet ein bunter Rahmen um den iPhone-Bildschirm auf. Eine neue Methode zum Aufrufen gibt es auch: ein Doppeltipp auf das untere Ende des Sperrbildschirms.

Siri kann nun natürliche Sprache und selbst ausschweifende Anfragen deutlich besser verstehen – auch, wenn man mehrfach neu ansetzt. Der Assistent bekommt endlich ein Bewusstsein für das, was im Gespräch bereits gesagt wurde. So können Nutzer etwa Wanderrouten für eine Region erstellen lassen, wenn sie im Schritt davor Siri nach dem Wetter gefragt haben. Siri kann außerdem sehen, was auf dem Bildschirm passiert und direkt Informationen daraus ableiten. Taucht in einem Chat eine Adresse auf, kann der Assistent diese kopieren und damit etwa die Informationen des Kontakts ergänzen.

Eine grundlegende Neuerung ist, dass Eingaben auch in Form von Text möglich sind. Nutzer können sich frei entscheiden, welche Methode sie gerade verwenden möchten, und jederzeit wechseln. Siri bekommt außerdem die Fähigkeit, kleine Schritt-für-Schritt-Anleitung zu erstellen. Nutzer müssen lediglich die Funktion beschreiben, die sie suchen und Siri erstellt die Instruktionen als Text.

Integration von ChatGPT

Im Mai hatte Apple einen Deal mit KI-Unternehmen OpenAI unterzeichnet, das unter anderem für die Entwicklung des Marktführers ChatGPT verantwortlich ist. Apple integriert grundlegende Funktionen des Chatbots in seine Betriebssysteme. Zwar gibt es keine eigene App. Aber überall dort, wo ChatGPT verfügbar ist, erscheinen entsprechende Flächen.

Siri kann etwa direkt an den Chatbot verweisen, wenn es um komplexere Anfragen geht. Etwa welche Pflanzen gut zu einer Szene in einem Bild passen würden. Beim Verfassen eines Textes können Nutzer auf ChatGPT zugreifen, um einen komplett neuen Text basierend auf einer Idee zu erstellen.

Bei all diesen Funktionen fragt Apple Intelligence explizit nach, ob Nutzer die relevanten Informationen an ChatGPT weitergeben möchten. Die Integration ist kostenlos für Besitzer kompatibler Geräte (iPhone 15 Pro/Pro Max, sowie Macs und iPads mit M1 oder neuer) und startet im Laufe des Jahres 2024. Das Feature verwendet GPT 4.o und setzt keine Anmeldung bei OpenAI voraus. Nutzer können jedoch ihren OpenAI-Account verwenden, um auf Bezahl-Funktionen von ChatGPT auch auf Apple-Geräten zuzugreifen.

Laut Insidern Von diesem Produkt ist Apple selbst noch nicht ganz überzeugt

Wegen EU-Vorgaben Größte Apple-Neuheit kommt nicht nach Deutschland

Amazon fährt Geldmittel für Alexa stark zurück Bleibt am Ende von den Sprachassistenten nur noch Siri übrig?

Apple Intelligence ist Nachzügler

Apple ist recht vorsichtig, was den Einsatz neuer Technologien in seinem Kerngeschäft iPhone – und damit auch iOS – angeht. Während Unternehmen wie OpenAI, Microsoft, Google und Meta bereits um die Vorherrschaft auf dem Markt für Künstliche Intelligenz (KI) ringen, ist Apple bislang außen vor.

Während die Konkurrenten ihre Large Language Models (LLMs; dt. „großes Sprachmodelle“) und generative KI stetig erweitern, hält sich der iPhone-Hersteller zurück. Zwar sagte CEO Tim Cook bereits im September 2023 gegenüber „Forbes“, dass Apple seit Jahren an generativer KI forsche – bislang war davon jedoch nicht viel zu sehen.

Apple zufolge findet ein Großteil der KI-Verarbeitung auf dem Gerät selbst statt, um die Sicherheit zu erhöhen. Lediglich anspruchsvolle Aufgaben werden in die Cloud ausgelagert.